En s’entraînant sur du contenu créé par des artistes, des auteurs, des vidéastes, les IA génératives bousculent leurs droits. Un état de la situation en 25 questions très simples et autant de réponses volontairement didactiques.

En à peine quelques mois, l’intelligence artificielle a révolutionné le quotidien de millions de gens dans le monde tout comme la pratique de nombreux créateurs. Or, ces IA dites « génératives » ont aussi été entraînées avec du contenu protégé par le droit d’auteur. Le Journal des Arts a demandé à Xavier Près (cabinet Valther), avocat spécialisé en droit de la propriété intellectuelle et en droit du numérique qui assiste de nombreux opérateurs culturels, de répondre le plus simplement possible à 25 questions sur ces IA, leur encadrement juridique et leur rapport avec le droit d’auteur.

L’IA est difficile à définir car il en existe de plusieurs types et parce qu’elle met en œuvre des technologies en rapide évolution. En simplifiant, il s’agit d’une famille de technologies capables de performances habituellement associées à l’être humain pour exécuter une tâche, faire des prédictions, résoudre un problème, générer un contenu, etc. Le Règlement européen sur l’IA (voir Q. 13) parle de « système d’intelligence artificielle ». La définition est articulée autour de sept éléments : il s’agit d’un (i) système, (ii) autonome, (iii) adaptable après son déploiement, (iv) dont les objectifs ont été déterminés et (v) qui déduit des sorties (comme des prédictions, du contenu, des recommandations ou des décisions), (vi) à partir des données d’entrée qu’il reçoit et (vii) qui sont susceptibles d’influencer les environnements physiques ou virtuels. L’IA repose principalement sur des algorithmes complexes, souvent nourris par de grandes quantités de données. Elle est désormais présente dans tous les secteurs, y compris dans nos vies quotidiennes, qu’il s’agisse de la reconnaissance faciale intégrée dans nos smartphones pour les déverrouiller ou des applications proposant des informations sur le trafic en temps réel pour optimiser ses trajets sur la route.

À la différence de l’IA dans son acception habituelle qui analyse et classe des données, l’IA générative produit automatiquement des contenus de différentes natures (textes, images, vidéos, sons, codes informatiques…) en réponse à une. ou plusieurs instructions (« prompts » en anglais). Les exemples sont nombreux : ChatGPT répond à des questions, génère du contenu. DALL·E, Midjourney ou Stable Diffusion sont plus particulièrement utilisés pour la génération d’images. Gemini est l’assistant conversationnel développé par Google et génère du texte, des traductions, du code informatique, mais aussi des images, des dessins, des sons, de la musique et des vidéos. Perplexity est un moteur de recherche conversationnel qui génère des réponses documentées en citant ses sources. Sans oublier Mistral, startup française qui propose des modèles open source et qui a notamment lancé Le Chat, un robot conversationnel. Ou encore les IA chinoises avec notamment DeepSeek qui a vocation à concurrencer ChatGPT et Ernie Bot, l’IA de Baidu le Google chinois.

Les IA génératives reposent sur des modèles probabilistes : à partir d’une instruction fournie par un utilisateur, elles calculent la probabilité d’une suite d’éléments, cohérente par rapport à la question posée et aux données ayant servi à leur apprentissage. À partir de ces données, elles apprennent à prédire le mot suivant (pour du texte) ou la séquence suivante, à savoir le pixel ou le son le plus proche de l’image ou de la vidéo, en fonction de ce qui leur semble le plus « vraisemblable ». C’est ce calcul de la combinaison de mots, d’images ou de sons la plus probable qui permet aux IA de générer des réponses a priori cohérentes. Mais il n’y a aucune pensée ou conscience comme chez un être humain qui viendrait produire ce contenu et vérifier sa vraisemblance.

Parce que l’IA ne « réfléchit » pas au sens de ce qu’elle produit. Les sorties (ou « output ») sont a priori cohérentes ; elles ont l’apparence de la vraisemblance. Mais aucune garantie n’existe sur leur exactitude. Il peut y avoir plusieurs sorties différentes pour une même requête, ces divergences résultant de la variabilité interne du modèle et de la sélection des solutions les plus probables. Les IA ne suivent pas des règles fixes, elles calculent toutes les options possibles et la réponse la plus plausible est produite, mais de manière aléatoire. Cette approche probabiliste comporte donc nécessairement un aléa et par conséquent un risque de générer des résultats erronés, absurdes ou trompeurs. Le phénomène est connu et porte le nom d’« hallucinations ».

Plusieurs facteurs peuvent les expliquer, par exemple des données d’entraînement insuffisantes ou biaisées. Car en ce cas, le modèle peine à produire des résultats fiables et comble les lacunes par un contenu incorrect ou fabriqué. Un avocat new-yorkais l’a appris à ses dépens : il a été confondu pour avoir produit lors d’un procès des décisions judiciaires imaginaires qu’il n’avait pas pris soin de vérifier. Il est assez aisé de faire halluciner une IA générative car elle est configurée pour nécessairement produire une réponse… au risque de l’inventer de toutes pièces.

Entraîner une IA générative signifie lui faire apprendre à partir d’un très grand volume de données (textes, images, sons, etc.) pour qu’elle comprenne les structures et les relations dans ces données. Pendant cet entraînement, l’IA ajuste ses paramètres internes pour améliorer ses prédictions, notamment pour générer la suite logique d’une phrase ou la continuation d’une image. Après cet apprentissage, l’IA est capable de générer du contenu nouveau et cohérent à partir d’une simple requête. L’apprentissage s’opère sur de grands ensembles de données : plus elles sont nombreuses, plus la qualité du modèle est grande. Pour comprendre et générer un texte pertinent, une IA générative doit avoir été exposée à des millions de phrases variées issues de livres, d’articles, de journaux, de conversations. Si le volume de données est trop petit, le modèle risque de ne pas saisir le sens ou les nuances d’un contenu (texte ou image), ce qui affectera la qualité et la précision des réponses générées.

Les données utilisées sont diverses. Elles diffèrent selon les modèles mais peuvent être composées de textes, d’images, de sons, de vidéos, etc. Il est d’usage de distinguer les données intégrées en amont pour enrichir l’IA (« input ») et les résultats générés en aval par l’IA en réponse à un prompt (« output »). Cette distinction est toutefois à nuancer car les résultats sont également parfois utilisés à titre de données d’entraînement. Tout comme les prompts. De sorte qu’il est conseillé d’être particulièrement vigilant lorsque l’on utilise une IA, spécialement lorsque des données confidentielles sont utilisées, par exemple en entreprise.

Ces données proviennent de sources multiples, notamment Internet où les données y sont aspirées selon différentes techniques automatisées telles que le « web scraping » permettant d’extraire, de collecter et de traiter des données après les avoir transformées ou converties dans un format spécifique exploitable. Les bases de données sont également largement exploitées (bibliothèques d’images ou de sons), tout comme des jeux de données collectées spécifiquement pour entraîner une IA. Plus elles sont diverses, nombreuses et de qualité, plus l’IA préalablement entraînée sur ces données aura de chances d’être elle-même fiable et robuste. Et inversement. Les grands systèmes d’IA génératives ont déjà épuisé la quasi-totalité des ressources disponibles sur Internet et sont désormais entraînés sur des données de synthèse générées par IA. Or ces données pourraient dégrader les performances des modèles d’IA avec pour conséquence une dégradation de la qualité des résultats et une amplification des biais.

Ce sont des robots (ou programmes informatiques) qui permettent de collecter automatiquement des données sur Internet pour ensuite les traiter, les classer et fournir des informations. Leur but premier est de cartographier le web, spécialement à des fins d’indexation par les moteurs de recherche. Le « web scraping » permet également d’extraire des données sur Internet, mais non plus de manière globale, mais de façon plus ciblée, selon un intérêt stratégique préalablement défini. Le « crawling » est effectué plutôt à des fins d’archivage (recherche et indexation de sites Internet par exemple), tandis que le « scraping » est effectué à des fins d’analyse en ce qu’il permet de transformer des informations non structurées présentes sur Internet en données structurées aisément exploitables. Ces techniques sont complémentaires : l’une trouve des liens, l’autre télécharge les données utiles à partir de ces liens.

Ils sont nombreux et aussi multiples que les données utilisées que sont les textes, dessins, images, photos, musiques, programmes audiovisuels ou radiophoniques, films, codes informatiques, bases de données, données personnelles, données confidentielles, etc. De différentes natures, ces données sont susceptibles d’être protégées juridiquement à plusieurs titres : droits d’auteur (pour les créations), droits voisins (des artistes-interprètes, des producteurs de vidéogrammes et de phonogrammes, des chaînes de TV et de radio, des éditeurs et agences de presse en ligne), droit des producteurs de bases de données ou encore droit des données personnelles (RGPD), droits de la personnalité (image, nom ou voix d’une personne), secret des affaires, etc. Protégées à plusieurs titres, leur utilisation peut donc nécessiter une pluralité d’autorisations émanant de titulaires de droits différents. Par ailleurs, les risques juridiques ne portent pas seulement sur les données utilisées pour entraîner les IA, ils concernent également l’utilisation des résultats , dès lors que ces derniers peuvent violer le droit de tiers (une œuvre protégée, l’image d’une personne, etc.).

Techniquement, une IA peut être entraînée à partir de données numériques gratuites ou payantes. La version en ligne du Journal des Arts comporte par exemple des données gratuites, accessibles par tous en un seul clic, et des données payantes, dont l’accès en intégralité est soumis à un abonnement. Cette barrière numérique (ou « paywall ») permet ainsi de restreindre l’accès à un contenu en ligne (articles, vidéos, podcasts, archives, etc.) et de le monétiser. Cette barrière numérique n’est toutefois pas infranchissable techniquement. De sorte qu’une IA peut avoir été entraînée sur des données payantes… qu’elle n’aura pourtant pas payées.

En France, deux textes dédiés à l’IA sont d’ores et déjà applicables : le Règlement européen du 13 juin 2024 établissant « des règles harmonisées concernant l’IA (RIA) » et la Convention-cadre du Conseil de l’Europe « sur l’IA et les droits de l’homme, la démocratie et l’État de droit » adoptée le 17 mai 2024 par le Conseil de l’Europe. Tandis que le second texte pose de grands principes généraux, le premier descend dans le détail et fixe pour l’ensemble des pays de l’UE un cadre unique concernant la mise sur le marché, la mise en service et l’utilisation de systèmes d’IA. Le RIA est aussi dense que complexe ; il se décline en 179 considérants, 113 articles et de nombreuses annexes. Et il s’applique largement, à tous opérateurs (fournisseurs, utilisateurs, importateurs, distributeurs) et tous secteurs confondus, à l’exclusion toutefois des finalités exclusivement militaires, de défense ou de sécurité nationale ou encore de recherche scientifique. Mais il n’existe pas encore en France de législations spécifiques propres à chacune des disciplines juridiques.

Le RIA a pour ambition de doter l’Union européenne d’un dispositif général, inédit au niveau mondial, pour permettre aux systèmes d’IA de se développer dans un cadre de confiance et dans le respect des droits fondamentaux et des valeurs de l’UE. Plus concrètement, le texte impose le respect d’obligations dont l’importance est fonction du risque. Les systèmes d’IA sont ainsi classés selon leur niveau de risque et les contraintes juridiques varient à proportion de ce dernier. Si le risque est inacceptable (notation sociale, techniques subliminales, etc.), les IA sont interdites. Si le risque est élevé (systèmes biométriques ou IA utilisées dans le recrutement, la sécurité, la santé, les infrastructures essentielles, etc.), le recours à l’IA est étroitement contrôlé. Si le risque est limité (IA générative), des obligations de transparence sont imposées et si le risque est minime, les contraintes le sont tout autant.

Le RIA impose à chaque opérateur fournissant ou déployant des systèmes d’IA à mettre en place une gouvernance rigoureuse pour maîtriser les risques associés au développement et au déploiement des systèmes d’IA. Les opérateurs, publics comme privés, doivent procéder à une cartographie de leurs systèmes d’IA, identifier pour chacun les risques y afférents et assurer une mise en conformité en fonction du risque associé à chaque IA et ce tout au long de leur cycle de vie. Ces obligations pèsent d’abord sur les fournisseurs (ou fabricants) des systèmes d’IA, mais elles concernent également les « déployeurs », c’est-à-dire « toute personne, physique ou morale, y compris une autorité publique, utilisant sous sa propre autorité un système d’IA, sauf lorsque ce système est utilisé dans le cadre d’une activité personnelle à caractère non professionnel ». Bref, toutes les entreprises sont visées, y compris l’administration. Si la version en ligne du JdA proposait par exemple un chatbot d’assistance à ses lecteurs, le JdA serait alors considéré comme « déployeur » au sens du RIA.

Oui, depuis le 1er août 2024. Mais son entrée en vigueur est progressive ; elle s’opère de manière échelonnée jusqu’en 2027 de façon à ce que chaque opérateur puisse se préparer. Ce délai permet au demeurant de mesurer le niveau de contraintes imposées aux acteurs économiques qui, pour se mettre en conformité, doivent mobiliser des ressources matérielles, humaines et financières importantes. Et attention, les sanctions sont lourdes.

Non, le RIA est un texte transverse qui relève du droit de la compliance en ce qu’il contraint les entreprises et les administrations à déployer des procédures essentiellement préventives afin d’éviter de s’exposer à des risques liés au non-respect de la réglementation. Sa philosophie est en ce sens très proche de la réglementation sur les données personnelles (RGPD). Le droit d’auteur y est néanmoins évoqué, notamment sous l’angle de la transparence, avec l’obligation faite aux fournisseurs de modèles d’IA générative de mettre en place une politique visant à se conformer au droit de l’Union en matière de droit d’auteur et de droits voisins, et notamment à mettre à la disposition du public un « résumé suffisamment détaillé » du contenu utilisé pour entraîner les IA. Cette obligation vise à permettre l’identification des données d’entraînement et à assurer l’effectivité du respect des droits des auteurs et des droits voisins, bref de l’ensemble des titulaires de droits sur des contenus protégés (textes, sons, images, animées ou non, codes informatiques, interprétations, programmes audiovisuels et radiophoniques, bases de données, etc.).

C’est tout l’enjeu ! Les IA sont souvent décrites comme des « boîtes noires » pour signifier qu’il est difficile à la fois de saisir leur fonctionnement, mais aussi d’identifier les milliards de données utilisées à titre d’entraînement. Or ce « résumé suffisamment détaillé » (voir Q.16) a pour objet de permettre d’identifier les données utilisées par les IA et ainsi aider les titulaires de droits à obtenir des informations pertinentes sur le contenu utilisé dans l’entraînement des modèles d’IA et partant à exercer et faire valoir leurs droits. Le RIA a confié au Bureau de l’IA la mission de proposer un modèle type de résumé détaillé. Le 24 juillet 2025, la Commission européenne à laquelle est rattaché le Bureau de l’IA a publié son modèle et l’a accompagné d’une notice explicative. Mais son contenu risque de décevoir les titulaires de droits. Le document identifie en effet trois grandes catégories d’informations à inclure dans le résumé, à savoir des « informations générales », une « liste des sources de données » et des « aspects pertinents liés au traitement des données ». Il n’impose toutefois pas la divulgation des détails concernant les données et les œuvres précises utilisées pour l’entraînement des modèles d’IA. Le dispositif ne contraint donc pas les fournisseurs d’IA générative à communiquer la liste exacte des œuvres utilisées pour l’entraînement d’un modèle, mais simplement les principaux ensembles de données qui ont été utilisés, tels que les grandes bases de données privées ou publiques, ainsi que les noms de domaine les plus pertinents. C’est donc vers le droit français qu’il faudra se tourner pour pallier les insuffisances des initiatives européennes.

Il n’existe pas encore en droit français de texte spécifique dédié à l’IA et au droit d’auteur. Une proposition de loi « visant à encadrer l’IA par le droit d’auteur » avait été déposée le 12 septembre 2023 à l’Assemblée nationale. Elle n’a toutefois pas été adoptée. Mais l’absence de réglementation spécifique au-delà des deux textes européens (voir Q. 12) ne signifie pas pour autant qu’il y aurait un vide juridique. À défaut de réglementation spécifique, le juriste fait application, lorsque c’est possible, des règles actuellement en vigueur. Autrement dit, les solutions du monde physique sont transposées aux réalités virtuelles. La plasticité du droit d’auteur le permet ; il s’est largement construit avec le progrès technique et a réussi à prendre en compte le disque, la radio, le cinéma, la TV, Internet, etc. Ainsi, il est possible dans certains contrats d’intégrer des clauses encadrant l’IA. Et sur le plan contentieux, le droit français comporte nombre de dispositions pour permettre la communication d’informations, telles que les données d’entraînement (voir Q. 6 à 8), préalablement à une action en justice ou au cours d’une instance.

Oui, en principe. Mais il existe un débat parmi les juristes quant à la question de savoir si l’utilisation d’une œuvre protégée (quelle qu’elle soit : œuvres littéraire, graphique ou plastique, audiovisuelle, photographique, logicielle, etc.) pour entraîner une IA, relève ou non du monopole de l’auteur et plus exactement de son droit de reproduction. L’opinion largement majoritaire considère toutefois que l’exploitation d’une œuvre de l’esprit pour entraîner une IA constitue une copie numérique et donc acte de reproduction soumis à l’autorisation préalable de l’auteur, sauf à pouvoir justifier du bénéfice de l’une des exceptions prévues par la loi.

Parmi les exceptions en vigueur, l’exception dite de « fouilles de textes et de données » est celle qui pourrait être invoquée avec le plus de chances de succès pour justifier l’absence d’autorisation préalable des titulaires de droit. Son bénéfice est toutefois loin d’être acquis. L’exception distingue deux cas : la première permet de réaliser des reproductions numériques d’œuvres sans autorisation des auteurs aux fins de la recherche scientifique par des institutions culturelles. Cette hypothèse ne concerne pas les IA génératives. La seconde hypothèse est applicable lorsque la fouille de textes et de données est réalisée pour d’autres finalités que la recherche scientifique, ce qui est le cas des IA génératives. L’exception est alors subordonnée à l’absence d’opposition (ou « opt out ») des titulaires de droits. Indépendamment de la mise en œuvre de cette faculté d’opposition et de ses difficultés d’application pratique, l’exception devrait dans cette hypothèse encore passer le test des trois étapes pour être applicable. Ce test soumet les exceptions à la triple obligation (i) d’être limitées à des cas spéciaux, (ii) de ne pas porter atteinte à l’exploitation normale de l’œuvre et (iii) de ne pas causer un préjudice injustifié aux intérêts légitimes de l’auteur. Or, ces deux dernières conditions semblent difficilement conciliables avec l’utilisation massive d’œuvres protégées au titre du droit d’auteur par les IA génératives et l’importance de ces dernières, qui sont désormais largement utilisées et, ce, dans quasiment tous les secteurs.

Ce sont celles de la contrefaçon : cessation des agissements ordonnée par un juge, le cas échéant sous astreinte, octroi de dommages et intérêts, mesures de publication de la décision pour le volet civil. Et pour le volet pénal : amende, peine de prison, fermeture d’établissement, etc. La contrefaçon sanctionne toute atteinte à un droit de propriété intellectuelle, dont le droit d’auteur. De sorte que toute utilisation d’une œuvre de l’esprit, sans autorisation préalable du titulaire de droits, est susceptible de constituer le délit de contrefaçon et donc d’être sanctionnée civilement et/ou pénalement. En France, aucune sanction n’a encore été rendue sur le terrain du droit d’auteur. Mais cela ne saurait tarder, car les grands systèmes d’IA n’ont pas attendu pour aspirer largement, sans autorisation, les contenus présents sur Internet. Les litiges vont se multiplier. Le Syndicat national de l’édition (SNE), la Société des gens de lettres (SGDL) et le Syndicat national des auteurs et des compositeurs (SNAC) ont ainsi assigné Meta le 6 mars 2025 au motif de l’utilisation, sans leur autorisation, d’œuvres protégées par le droit d’auteur pour l’entraînement de l’IA générative Llama.

Si une IA générative produit un résultat identique ou similaire à celui d’une œuvre protégée au titre du droit d’auteur et qu’aucune autorisation n’a été délivrée, l’auteur de l’œuvre en question peut alors agir en contrefaçon. Préalablement, il lui sera utile de faire constater le résultat généré par un commissaire de justice afin de faire valoir ses droits. Il est toutefois rare qu’une IA générative produise de tels résultats, car la plupart du temps les œuvres ne sont pas identifiables (ou difficilement) dans les résultats produits par l’IA. Si tel est le cas, tant mieux, la preuve de la contrefaçon alléguée n’en sera que plus facile. Mais si tel n’est pas le cas, l’auteur n’est pas pour autant démuni. Car il faut rappeler que la simple utilisation d’une œuvre protégée pour entraîner une IA peut suffire à caractériser le délit de contrefaçon et, ce, indépendamment du résultat produit. La preuve de la contrefaçon sera toutefois plus difficile à rapporter, car il faudra alors ouvrir le capot de la machine et voir ce qui se trouve à l’intérieur, dans la « boîte noire », avec les difficultés précitées (voir Q. 17).

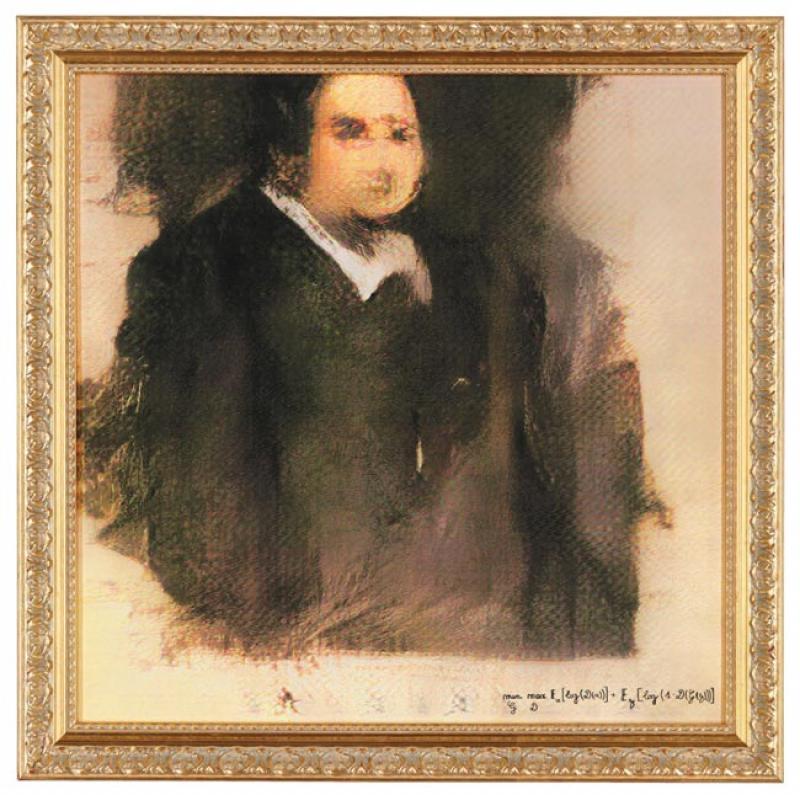

Les IA génératives sont capables de produire de manière automatique des résultats sous la forme de contenus relevant de genres différents (texte, image, vidéo, musique, logiciel, etc.). Pour que ces contenus puissent être protégés par le droit d’auteur, il faut qu’il s’agisse d’une création de forme originale, forme et originalité étant les deux conditions d’accès à la protection. Or, selon la conception personnaliste (ou humaniste) du droit d’auteur français, l’auteur d’une œuvre de l’esprit ne peut être qu’une personne physique, seule capable de concevoir une création originale qui lui est propre, reflétant sa personnalité, par la manifestation de choix libres et créatifs. Par conséquent, un contenu entièrement généré par une IA ne saurait donc a priori être protégeable au titre du droit d’auteur. La conclusion est toutefois un peu rapide. Car tout devrait dépendre en pratique de la façon dont l’homme interagit avec la machine. Rien ne s’oppose en effet, pas plus le droit que la technique, à ce que par une série de requêtes exprimant des choix libres et créatifs, l’utilisateur puisse, dans le cadre d’un « dialogue itératif actif » avec la machine, concevoir une œuvre singulière portant l’empreinte de sa personnalité. Ce « dialogue itératif actif » avec la machine est essentiel, car il est de nature à réduire le caractère aléatoire des réponses probabilistes des IA génératives. Bien sûr, la qualification d’œuvre de l’esprit protégée par le droit d’auteur ne devrait pas soulever de difficultés lorsque les résultats générés par l’IA ne sont pas repris en tant que tels, mais sont retravaillés, « recréés » par l’homme en dehors de tout lien avec la machine.

Pas en France, il n’y a donc pas encore de jurisprudence. Mais en Chine, les juges n’hésitent pas à reconnaître la protection par le droit d’auteur aux créations générées à l’aide d’une IA. Ainsi, la Beijing Internet Court a accordé, le 27 novembre 2023, la protection par le droit d’auteur à une œuvre générée par l’IA Stable Diffusion à la suite d’une série de prompts d’un utilisateur, dans les termes suivants : « Ses réglages minutieux et ses choix esthétiques effectués durant la création de l’image ont reflété un processus de décision personnalisé, conférant ainsi à l’œuvre un caractère d’originalité ». Aux États-Unis, la jurisprudence oscille entre reconnaissance et refus de protection par le copyright. Mais au-delà de ces décisions d’espèce, une position claire a été exprimée par le bureau américain du droit d’auteur.

Dans un rapport de janvier 2025, l’US Copyright Office (USCO) a formulé quatre recommandations principales. Le rapport a d’abord observé qu’un contenu entièrement généré par une IA n’est pas protégeable par le copyright. Il a ensuite précisé que l’utilisation de l’IA pour assister la créativité humaine n’affecte pas l’éligibilité à la protection par le copyright, sous réserve toutefois que les résultats soient « suffisamment » contrôlés par l’homme. Il a ensuite ajouté que la question de savoir si la contribution humaine aux résultats est « suffisante » doit être analysée au cas par cas. Enfin, il s’est prononcé sur la protection de contenus générés à l’aide de prompts en observant que les prompts ne fournissent pas à eux seuls un contrôle suffisant pour que l’on puisse dissocier ce que l’artiste a créé de ce qui a été généré automatiquement pour conclure, en ce cas, à un refus de protection. Sur ce dernier point, la solution est donc assez différente de celle des tribunaux chinois.

L’accès à la totalité de l’article est réservé à nos abonné(e)s

L’IA et le droit d’auteur en 25 questions

Déjà abonné(e) ?

Se connecterPas encore abonné(e) ?

Avec notre offre sans engagement,

• Accédez à tous les contenus du site

• Soutenez une rédaction indépendante

• Recevez la newsletter quotidienne

Abonnez-vous dès 1 €Cet article a été publié dans Le Journal des Arts n°664 du 31 octobre 2025, avec le titre suivant : L’IA et le droit d’auteur en 25 questions